Posted on 2013-03-02 17:28

鑫龙 阅读(4046)

评论(0) 编辑 收藏 引用 所属分类:

Hadoop

jar -cvf xxx.jar .

hadopp jar xxx.jar clalss-name [input] [output]

----------------------------------------------------------------------

hadoop jar hadoop-0.20.2-examples.jar [class name]的实质是:

1.利用hadoop这个脚本启动一个jvm进程;

2.jvm进程去运行org.apache.hadoop.util.RunJar这个java类;

3.org.apache.hadoop.util.RunJar解压hadoop-0.20.2-examples.jar到hadoop.tmp.dir/hadoop-unjar*/目录下;

4.org.apache.hadoop.util.RunJar动态的加载并运行Main-Class或指定的Class;

5.Main-Class或指定的Class中设定Job的各项属性

6.提交job到JobTracker上并监视运行情况。

注意:以上都是在jobClient上执行的。

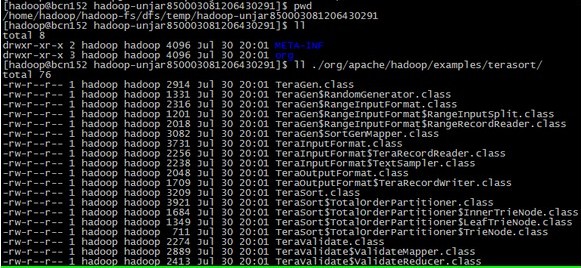

运行jar文件的时候,jar会被解压到hadoop.tmp.dir/hadoop-unjar*/目录下(如:/home/hadoop/hadoop-fs/dfs/temp/hadoop-unjar693919842639653083, 注意:这个目录是JobClient的目录,不是JobTracker的目录)。解压后的文件为:

drwxr-xr-x 2 hadoop hadoop 4096 Jul 30 15:40 META-INF

drwxr-xr-x 3 hadoop hadoop 4096 Jul 30 15:40 org

有图有真相:

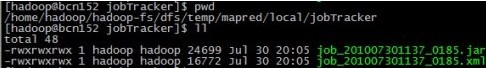

提交job的实质是:

生成${job-id}/job.xml文件到hdfs://${mapred.system.dir}/(比如hdfs://bcn152:9990/home/hadoop/hadoop-fs/dfs/temp/mapred/system/job_201007301137_0012/job.xml),job的描述包括jar文件的路径,map|reduce类路径等等.

上传${job-id}/job.jar文件到hdfs://${mapred.system.dir}/(比如hdfs://bcn152:9990/home/hadoop/hadoop-fs/dfs/temp/mapred/system/job_201007301137_0012/job.jar)

有图有真相:

生成job之后,通过static JobClient.runJob()就会向jobTracker提交job:

JobClient jc = new JobClient(job);

RunningJob rj = jc.submitJob(job);

之后JobTracker就会调度此job,

提交job之后,使用下面的代码获取job的进度:

try {

if (!jc.monitorAndPrintJob(job, rj)) {

throw new IOException("Job failed!");

}

} catch (InterruptedException ie) {

Thread.currentThread().interrupt();

}